O estudo da natureza em busca da verdade é o que denominamos como ciência.

Toda ciência que temos torna-se completa quando consegue atender a toda nossa realidade. A partir do momento em que se torna falha, deixa de ser completa e a busca por novos conhecimentos para completá-la torna-se incessante.

As teorias físicas apresentadas até o fim século XIX eram conceituadas por alguns cientistas renomados como a “Teoria do Tudo”, pois, para eles, todos os fenômenos físicos poderiam ser explicados pelos conhecimentos do momento presente.

No início do século XX, vários cientistas deram dinamicidade ao conhecimento, demonstrando que a ciência não era estagnada.

Toda física construída até o fim do século XIX tornou-se limitada no início do século XX, onde a teoria da relatividade, a física quântica e a física nuclear “nasciam fervorosas” e “carregadas” de novos conhecimentos, dando origem ao que chamamos de Física Moderna.

Física Moderna

A história da física moderna começou no momento em que o espectro da radiação térmica passou a ser analisado através do estudo da radiação emitida por corpos negros.

Quem primeiro estudou a emissão e absorção do calor, chegando à conclusão sobre corpos negros, foi o físico alemão Robert Kirchhoff. Depois dos estudos sobre esse espectro (o corpo negro), sua utilização foi muito importante para o início da física moderna. Em razão da facilidade de se construir esse espectro, todos os estudos sobre a radiação térmica passaram a ser feitos a partir do corpo negro.

Baseado nos gráficos gerados a partir da emissão da radiação dos corpos negros, o também físico alemão, Max Planck buscou chegar a uma equação matemática capaz de explicar o fenômeno causado pela intensidade de radiação emitida pelo corpo negro, tudo isso porque a radiação emitida pelo corpo negro produzia gráficos bem definidos, mas até então inexplicáveis aos olhos da física clássica.

O estudo dos gráficos para se chegar a uma equação matemática era sempre feito da seguinte forma: os físicos partiam dos princípios da física clássica para tentar chegar aos precisos gráficos.

Planck resolveu inverter a ordem, partindo dos gráficos gerados para uma possível equação. Quando conseguiu o feito, Planck foi buscar uma justificativa para a descoberta, afinal alguma teoria precisava comprovar o que ele havia desvendado. A teoria de entropia e a probabilidade de Boltzmann foram a chave para a abertura do conhecimento, em que era possível analisar uma equação matemática e entendê-la teoricamente.

Entre todas essas descobertas, Planck trazia também à tona uma nova constante, que em sua homenagem foi chamada de Constante de Planck. Ela é representada pela letra h e tem o valor de:

h = 6,63.10-34 J.s

Segundo Max Planck, a energia só existe na natureza em quantidades “discretas”, o que ele chamou de quanta de ação.

É interessante relacionar todo este estudo ao nosso cotidiano. Muitas vezes nos perguntamos: “E o que essa física moderna tem a ver comigo?”.

Na verdade, tudo. Toda essa tecnologia que temos hoje partiu desses princípios. Veja:

• Ondas de rádio

• Luz infravermelha

• Ondas de Raios X

• Luz visível

Tudo isso é exemplo de consequências geradas pelo estudo do espectro da radiação do corpo negro.

Aparelhos como o computador e todos os outros dispositivos eletrônicos da conhecida high-tech existem em razão da física moderna.

Vemos então que nosso mundo moderno depende diretamente de todos os estudos começados desde os primórdios da humanidade e continuados por personalidades como Max Karl Ernest Ludwing Planck (1858-1947), o pai da física quântica.

2005: Ano Mundial da Física

Em 2005 foi comemorado o Ano Mundial da Física. A festa foi idealizada pela comunidade científica, a fim de homenagear os 100 anos de publicação das teorias do físico alemão Albert Einstein.

As teorias publicadas por Einstein e comemoradas em 2005 foram:

• A teoria da relatividade

• Física Quântica

• Teoria do Movimento Browniano

Com suas publicações, Einstein revolucionou a história da Física, porque mostrou que nada era absoluto, não existindo, pois, um referencial absoluto e mostrou que tudo é relativo. Ele provou isso quando nos apresentou a teoria da relatividade, que nos trouxe uma nova concepção para a massa de um corpo.

E = mc²

Onde:

E = energia

m = massa

c = velocidade da luz no vácuo

Einstein nos mostrou, a partir da relatividade, que a velocidade da luz no vácuo é a velocidade limite para qualquer corpo de massa real.

Também trouxe ao conhecimento da humanidade a possibilidade de a luz ser formada por partículas.

Sobre a velocidade da luz no vácuo (c), Einstein postulou que ela é a mesma para todos os observadores, independente do seu movimento ou de sua fonte.

Essas teorias propostas por Einstein intrigam os estudiosos, pois impossibilitam saber se a simultaneidade de eventos é real.

Voltando para as comemorações de tudo isso, a abertura oficial aconteceu em Paris, França, na sede mundial da UNESCO entre os dias 13 e 15 de janeiro de 2005.

Já os festejos no Brasil tiveram seu início oficial no Simpósio Nacional do Ensino de Física no Rio de Janeiro, entre os dias 24 e 28 de janeiro do mesmo ano.

Durante todo o ano de 2005, não só os físicos, mas toda a população civil interessada em aprender e entender um pouco mais sobre as teorias de Einstein, tiveram acesso a palestras, feiras e diversos eventos voltados para esse fim.

A descoberta do núcleo e os atuais ramos de estudo

No início do século XX a única notícia, na área da Física, que se sabia era que na estrutura do átomo existiam elétrons.

Apesar de ter sido descoberto por Thomson em 1897, a massa do átomo ainda era algo desconhecido, tornando impossível dizer quantos elétrons um átomo continha.

Os físicos já sabiam que os átomos eram eletricamente neutros e por isso tinham que conter cargas positivas, mas estas eram ainda desconhecidas.

Em 1911 Rutherford sugeriu, através de bases de resultados experimentais de sua equipe, que essa carga estivesse presente no centro do átomo, formando um núcleo, responsável pela maior parte da massa do átomo.

Naquela época Rutherford já sabia que certos elementos considerados radioativos se transformam espontaneamente em outros elementos, emitindo partículas alfa (α), com energia aproximada de 5,5 MeV. Sabe-se hoje que essas são partículas do átomo de hélio.

A ideia era fazer com que as partículas alfa incidissem em uma folha fina de metal a fim de medir o desvio da trajetória das partículas ao passarem pelo material. O resultado obtido foi o espalhamento extremamente elevado, próximo da temperatura de 180°, o que foi uma grande surpresa, visto que o ângulo de espalhamento é pequeno para a maioria das partículas.

A surpresa de Rutherford foi tamanha, pois na época em que o experimento foi realizado a maioria dos físicos acreditava no modelo conhecido como “pudim de passas”, proposto por Thomson, onde a carga positiva do átomo estava uniformemente distribuída em todo o átomo, e os elétrons vibravam em torno de posições fixas no interior dessa esfera de carga positiva.

A força experimentada por uma partícula alfa ao passar por uma esfera de carga positiva do tamanho de um átomo produziria uma deflexão menor que 1°. Para sofrer uma deflexão maior que 90°, Rutherford raciocinou que a partícula alfa teria que ser submetida a uma força considerável, sendo possível sua explicação se a carga positiva, ao invés de se espalhar por todo o átomo, se concentrasse numa região central pequena, podendo esta partícula alfa se aproximar da carga positiva sem atravessá-la, o que tornaria essa aproximação uma força considerável.

Os atuais ramos de estudo da Física Nuclear são basicamente o núcleo atômico e suas propriedades, pois esses núcleos possuem propriedades que podem ser classificadas como estáticas e dinâmicas, sendo que são analisadas através de modelos nucleares baseados na mecânica quântica, relatividade e teoria quântica de campos. A descoberta de que os núcleos (prótons e nêutrons) são, na realidade, sistemas compostos, redirecionou o interesse dos físicos nucleares para a investigação dos graus de liberdade de quarks e, com isto, atualmente os domínios de pesquisa da Física Nuclear e da Física das Partículas Elementares se tornaram interligados.

As Forças Fundamentais da Natureza

Em meio à infinidade de fenômenos físicos, existem quatro interações fundamentais envolvidas. Essas interações são forças, sendo elas: força gravitacional, força eletromagnética, força nuclear forte e força nuclear fraca.

Força Gravitacional

A atração mútua entre corpos em razão de suas massas é denominada força gravitacional.

Força Eletromagnética

A atração ou repulsão entre corpos em razão de suas cargas elétricas e/ou sua magnetização é denominada força eletromagnética .

Força Nuclear Fraca

Força desenvolvida entre os léptons e os hadrons é denominada força nuclear fraca.

Força Nuclear Forte

A força que mantém a coesão nuclear e a união entre quarks é denominada força nuclear forte.

Unificação das Forças Fundamentais

Cientistas estão tentando unificar as forças fundamentais; mas as tentativas ainda não obtiveram sucesso. Cabe a nós aguardarmos o que o mundo científico nos reserva e se a unificação das quatro forças fundamentais será possível.

Constante de Planck

O físico alemão Max Karl Ernst Ludwig Planck (1858-1947) começou a estudar a radiação do corpo negro em 1897, buscando resoluções teóricas de uma equação proposta por Wilheim Wien, também físico alemão.

Logo foram detectadas na fórmula de Wien grandes divergências com os resultados experimentais para baixas frequências. Planck então procurou saber quais eram esses resultados e buscou uma expressão que se ajustasse.

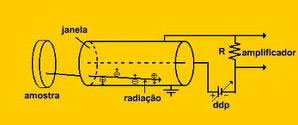

O espectro da radiação do corpo negro foi o mais importante desses estudos, pois a radiação emitida pelo corpo negro é dispersada por um prisma de material não absorvente e dirigida a um detector que mede a intensidade de cada frequência da radiação. Tal montagem experimental permite a obtenção de gráficos da potência da radiação emitida pelo corpo negro que atinge o detector por área e frequência (W/m².Hz), para cada temperatura em função da frequência.

Apesar de esses gráficos terem características bem definidas, a física clássica não conseguia explicá-los, não sendo possível obter uma equação matemática partindo dos princípios da física clássica, conhecidos na época.

Então Planck, “num ato de desespero”, resolveu inverter o processo teórico, partiu dos gráficos para chegar à equação. Não satisfeito, passou a buscar uma justificativa teórica que a fundamentasse. Encontrou entre os conceitos de entropia e probabilidade da termodinâmica uma função onde todos os termos tinham um significado físico. Nasceu, então, a constante de Planck.

h = 6,63 .10-³4 J.s

h = constante de Planck

A energia (ação) só existe na natureza em valores discretos em quanta de ação, ou seja, esse processo dá à natureza um caráter descontínuo, inaceitável para a física clássica.

Resumo: Planck descobriu que a ação, grandeza que a natureza utiliza sempre na menor quantidade possível, não pode ser infinitamente pequena, porque ela tem um valor limite; embora ele seja muito pequeno, esse valor é imposto pela própria natureza, h = 6,63 .10-³4 J.s

Contração do Comprimento

As leis da física são as mesmas para qualquer referencial inercial, e a velocidade da luz independe da fonte emissora e de quem a recebe, sendo ela (velocidade da luz)

constante em todos os sistemas inerciais de referência.

Os postulados citados acima, propostos por Albert Einstein, foram os pilares para o desenvolvimento da Teoria da Relatividade Especial, que tem como uma de suas implicações a contração do comprimento.

A expressão matemática a seguir relaciona o comprimento L que é medido para um referencial x que se encontra em movimento em relação ao referencial x’ e o comprimento L’ (medido em x’).

![]()

O comprimento relativístico

L = comprimento medido no referencial x (m)

L’ = comprimento medido no referencial x’ (m)

u = velocidade relativa entre o referencial x e x’ (m/s)

c = velocidade da luz no vácuo (m/s)

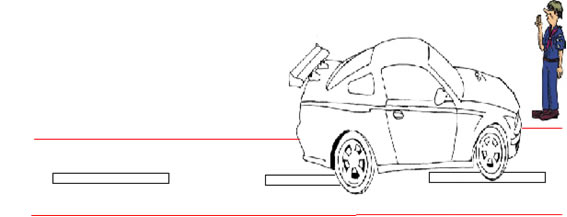

Se o rapaz de azul (fixo em relação ao carro) for medir o tamanho do carro, e se o mesmo estiver com velocidade próxima a da luz; ele poderá observar que o carro ficará menor em relação a uma medida feita deste carro quando ele estiver fixo com relação ao rapaz.

Ao medir o comprimento em um referencial em relação ao referencial de um determinado corpo em movimento, esta medida será menor do que o comprimento medido no referencial em relação ao qual o corpo se encontra em repouso e a contração sofrida por este corpo ocorre na direção do movimento.

Cromodinâmica e Eletrodinâmica Quântica

A cromodinâmica quântica é a teoria dos quarks (um dos elementos básicos que constituem a matéria) e dos glúons (um mediador de força forte).

É uma teoria que “analisa” explicações sobre como as partículas elementares se comportam.

Essa teoria é considerada a fundamental das interações fortes, e faz parte da teoria conhecida como Modelo Padrão das Partículas Elementares e das Forças Fundamentais da Natureza.

No que se refere ao entendimento da estrutura fundamental da matéria e seus progressos alcançados no século XX, tendo seu início com a mecânica quântica, levando entendimento e descobertas da estrutura atômica e dos avanços da energia nuclear, a cromodinâmica quântica é o resultado dos progressos alcançados.

Mas mesmo com tais progressos, a matemática ainda não dispõe de ferramentas em sua natureza analítica capazes de tirar predições da teoria.

Eletrodinâmica quântica ou segunda quantização é a teoria responsável por realizar quantização dos campos, sendo que a mecânica quântica realiza apenas a quantização da matéria.

Essa teoria considera tanto a matéria quanto os condutores de força, proporcionando base teórica a serem analisadas entre as interações de radiações eletromagnéticas.

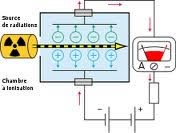

Detectores de Partículas

Detectores de partículas são aparelhos que identificam partículas subatômicas, tornando-as muitas vezes visíveis, ou seja, são baseados na transferência de parte ou toda a energia de radiação para a massa do detector, onde é convertida em uma forma mais acessível à percepção humana.

Para se deter partículas radioativas, a única possibilidade é usando paredes de chumbo, e os principais métodos de detecção desse tipo de radiação são:

• as chamadas câmaras de Wilson (que realizam um traçado do trajeto dessas partículas radioativas num gás saturado de vapor de água, onde os íons são produzidos com um feixe de raios X, ou gama, que são emitidos por uma fonte radioativa);

• os contadores de Geiger-Müller (responsável pela origem da cadeia de ionização que indicará a quantidade ou a presença de radiação através de um sinal audível), e alguns outros detectores que determinam o número dessas partículas

Contador de Geiger-Mülller - Aparelho que serve para medir a radiação emitida por uma fonte radioativa, utilizando a propriedade da ionização (retirada de elétrons) que a radiação possui.

Na física nuclear, a câmara de ionização funcionou como um dos primeiros detectores, que são aparelhos responsáveis pela medição da ionização de uma partícula incidente, além de serem capazes de identificar a passagem de partículas por meio de pulsos de carga elétrica, produzida nos dispositivos de detecção.

Câmara de Ionização

Existem também outros tipos de detectores de partículas capazes de permitir a observação da trajetória percorrida, são os chamados detectores de trajetórias.

• Câmaras de emulsões nucleares - são parecidas com as câmeras fotográficas, mas com o diferencial de serem ativadas com partículas carregadas.

• Câmaras de Bolhas - permitem a visualização das trajetórias de partículas emitidas pelos materiais radioativos, e são feitas de uma cavidade cujo volume pode ser controlado por um pistão.

• Câmaras de Centelas - partículas que possuem um alto índice de energia, ionizam o ar e o gás que estão entre as placas carregadas.

• Câmara de faíscas - passagem de uma partícula carregada através de duas placas metálicas colocadas em um meio gasoso e muito próximas uma da outra, a câmara de faíscas faz saltar uma faísca (centelha) entre essas placas. A associação de vários pares dessas placas permite a determinação da trajetória da referida partícula.

• Contador de cintilação - contadores nos quais a partícula carregada, ao atravessar o material cintilante sólido ou líquido, provoca a emissão de fótons que se converterão em elétrons em razão do efeito fotoelétrico.

• Partículas Neutras - diferentes das partículas carregadas, que são mais fáceis de se identificar, as neutras precisam sofrer algum tipo de reação que ionize o material.

Dualidade Partícula Onda

Louis Victor Pierre Raymond, conhecido como Louis de Broglie (1892 – 1987), físico francês, introduziu em sua tese de doutorado a teoria de onda de elétrons, tese esta que lhe rendeu o Prêmio Nobel em física no ano de 1929.

A hipótese de a matéria ter comportamento ondulatório (onda de elétrons) fora criticada por grande parte da comunidade científica quando lançada, porém comprovada mais tarde experimentalmente.

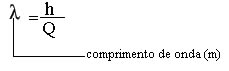

A dualidade partícula-onda é expressa matematicamente relacionando o comprimento de onda associado à matéria em função do momento que a mesma possui (ver equação 1).

Equação 1

Onde h representa a constante de Planck (m2 kg / s) e Q a quantidade de movimento (kg.m/s)

O fenômeno difração, antes da hipótese de de Broglie, era apresentado somente por ondas. Com a proposta de ondas de matéria, verificou-se que feixe de elétrons apresenta este fenômeno também se estendendo para qualquer tipo de matéria.

O microscópio eletrônico tem em seu princípio de funcionamento o comportamento partícula-onda.

Efeito Compton

Arthur Holly Compton (1892 – 1962), físico americano, observou no ano de 1923 o Efeito Compton pelo qual recebera o Prêmio Nobel em física, no ano de 1927.

Em seus experimentos, Compton fez raios x incidir sobe um alvo de grafite. O comprimento de onda incidente (raios x) fora medido inicialmente e era único. Após a colisão entre raios x e o alvo, verificou-se o espalhamento dos raios x.

Os raios espalhados foram analisados e Compton notou a presença de raios x com o mesmo comprimento de onda do que fizera incidir no alvo, e também raios x com menor comprimento de onda.

Os raios emergentes que possuem o mesmo comprimento de onda do incidente é proveniente da interação entre raios x e elétron do alvo de grafite, no qual o elétron absorve toda a energia transportada pelos raios x e recua de orbital. Após um intervalo de tempo, o elétron retorna ao orbital em que estava emitindo toda a energia que fora absorvida.

Os raios emergentes possuem menor comprimento de onda que o incidente em razão da interação entre raios x e elétron do alvo de grafite, no qual o elétron absorve parcialmente a energia* transportada pelos raios x e a energia restante estará associada aos raios emergentes, que possuirão menor comprimento de onda que os incidentes.

Esse efeito ocorre em virtude da natureza dual da luz, que neste fenômeno comporta-se como partícula no qual os raios x recebem a denominação de fótons.

*a energia ser transferida parcialmente ao elétron não quer dizer que o fóton de raios x fora dividido, pois o fóton é indivisível. O que acontece é transferência de momento, o que acarreta variação em sua energia.

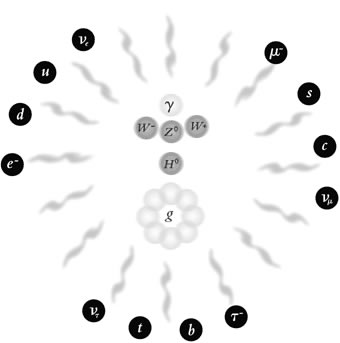

Física de Partículas

A descoberta de novas partículas elementares começou a acontecer entre 1932 e 1947. A primeira dessas descobertas foi o neutrino, uma solução teórica do físico italiano Enrico Fermi proposta em 1933 para justificar alguns resultados inexplicáveis até então; mas a confirmação da existência da partícula só aconteceu, experimentalmente, vinte anos mais tarde.

Outra importante partícula proposta em 1935 pelo físico japonês Hideki Yukawa foi o fóton. Ele postulou que essa partícula era capaz de mediar interações ocorridas entre campos (no campo eletromagnético o fóton já era conhecido), mas poderia haver outras partículas que mediassem outras interações, afinal, são os fótons que informam a uma partícula carregada da existência de outra, para saber se devem se atrair ou repelir.

Além do fóton, a primeira partícula desse tipo foi o píon, descoberto em 1947 por uma equipe de físicos, entre eles o brasileiro César Lattes. Completava-se então neste ano um conjunto composto por catorze partículas elementares, identificadas teórica ou experimentalmente.

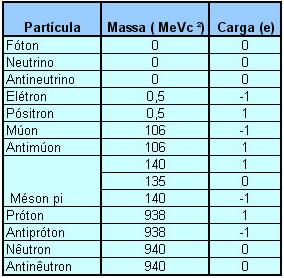

Conjunto das catorze partículas elementares

Todas as partículas tinham uma perfeita definição na estrutura da matéria, exceto o múon e o antimúon, dando aos físicos esperanças fundadas na ideia de que o universo microscópico estava totalmente descoberto e mapeado, mas como na física nada é absoluto e tudo é relativo, as certezas logo foram desfeitas.

Vinte anos depois da descoberta do píon, partindo de minucioso estudo de fotografias de raios cósmicos e do notável avanço tecnológico dos aceleradores de partículas, novas partículas elementares continuaram sendo descobertas (já somavam, aproximadamente, duzentas), o que preocupou os pesquisadores, afinal, até o final do século XIX imaginavam que existia apenas uma única partícula fundamental, e por isso não havia razão para tanta partícula elementar.

Organizando tantas partículas

Percebendo que era preciso organizar tamanha proliferação de partículas elementares e reduzir esse número, os físicos passaram a buscar bases que fundamentassem tal organização. O primeiro passo foi identificar semelhanças ou regularidades nas propriedades dessas partículas de maneira que fosse possível agrupá-las a fim de encontrar pontos em comum.

Identificaram então que na convergência entre as partículas Λ° e π+, deve ter surgido outro tipo de partícula antes da ramificação em O. Isso porque ela não aparece, pois seu tempo de vida é tão pequeno que não deixa rastro, ou este rastro é tão pequeno que se reduz ao ponto em que as partículas se cruzam.

Dessa forma foi possível mapeá-las e identificar suas semelhanças, sendo possível assim organizar o caos.

Em 1964, os físicos Georg-Zweig e Muray Gell-Man concluíram, de forma independente, que uma grande parte das partículas consideradas elementares era composta de outras partículas, estas sim elementares (ou até que se prove o contrário).

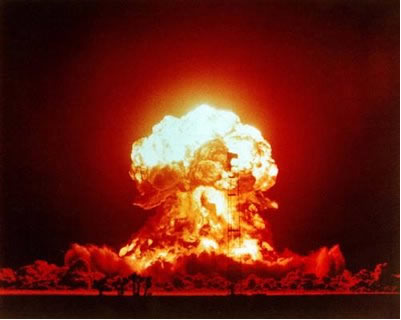

Fissão Nuclear

No final da década de 1930, a física Lise Meither e os químicos Otto Han e Fritz Stranssmann, trabalhavam em Berlim continuando o trabalho de Fermi e seus colaboradores, eles expuseram soluções de sais de urânio a nêutrons térmicos e descobriram que alguns produtos dessa interação eram radioativos.

Em 1939, um dos rádios nuclídeos produzidos dessa forma, foi identificado como sendo o bário.

Segundo os pesquisadores Meitner e Otto Frisch, um núcleo de urânio, depois de absorver um nêutron térmico, dividia-se com liberação de energia em dois fragmentos aproximadamente iguais, um desses era o bário. Frisch o chamou de fissão.

A Fissão Nuclear pode ser explicada através do modelo coletivo, que se baseia em uma analogia entre o núcleo e uma gota de líquido carregada eletricamente e dotada de certa energia de excitação. Para que a fissão aconteça, os fragmentos devem vencer uma barreira de potencial, para isso é preciso que a energia de excitação Em seja da mesma ordem que a altura da barreira Eb.

Resumindo: Para que o processo de fissão nuclear libere grandes quantidades de energia é preciso que um evento da fissão produza outros eventos, fazendo o processo se espalhar pelo combustível nuclear como o fogo em um pedaço de madeira. O fato que dois ou mais nêutrons serem liberados em cada evento de fissão é essencial para a ocorrência desse tipo de reação em cadeia, no qual cada nêutron produzido pode causar uma nova fissão que pode ser explosiva ou controlada, ou seja, é um processo onde ocorre a “quebra” do núcleo de urânio, e nesta quebra acontecem diversas reações nucleares simultaneamente.

Fusão Nuclear

A fusão nuclear é o excesso de energia resultante da combinação de dois núcleos leves que se unem a fim de formar um núcleo mais pesado. Esses dois núcleos leves participam de um processo que libera energia, sendo ela inibida pela barreira de Coulomb entre duas partículas de mesma carga, que impede que dois núcleos de cargas iguais se aproximem o suficiente pra que a interação forte predomine.

A fusão de átomos em grande escala só ocorre se a temperatura for suficiente para que os núcleos vençam a barreira por tunelamento. Isso pode acontecer aumentando a temperatura do material até que os núcleos tenham energia suficiente, fato ocasionado pela agitação térmica.

Fusão Termonuclear do Sol

A reação de fusão que acontece no Sol é um processo de várias etapas no qual a principal fonte de energia do sol é a queima termonuclear de hidrogênio para formar o gás hélio no ciclo próton-próton. Os elementos até A = 56 (pico da curva de energia de ligação) podem ser produzidos por outros processos de fusão depois que o suprimento de hidrogênio de uma estrela se esgotar.

A abundância de elementos mais pesados que o hidrogênio e o hélio na Terra sugere que o nosso sistema solar tenha se condensado a partir de uma nuvem interestelar que continha o resto dessas explosões.

Fusão Controlada

A fusão termonuclear é controlada, poderá tornar-se no futuro uma importante fonte de energia. As reações d-d e d-t são as mais promissoras. Um reator de fusão baseado na reação d-t deve satisfazer o critério de Lawson, alem de manter o plasma a uma temperatura suficiente.

Nos tokamaks o plasma é confinado por campos magnéticos, na fusão a laser é utilizado o confinamento inercial.

LHC - funcionamento até o final de 2012

Sabemos que o LHC (Large Hadron Collider) é o maior acelerador de partículas e o de maior energia existente. Ele está localizado próximo à fronteira da França com a Suíça, perto de Genebra. O principal foco desse acelerador de partículas é obter dados sobre colisões de feixe de partículas em altíssimas velocidades.

Em Genebra foi anunciado que o famoso e esperado acelerador de partículas, LHC, estará funcionando perfeitamente até o final de 2012 e que após esse período, o acelerador de partículas passará por manutenção técnica para funcionamento com altas energias no ano de 2014.

Informou a direção do centro europeu de pesquisas, Cern, que para o período entre 2011 e 2012 o acelerador funcionará com baixas energias, 3,5 TeV ( 3,5 teraelétron-volt).

Em comunicado realizado pelo diretor dos aceleradores do Cern, Steve Mayer, “Se o LHC continuar dessa forma e funcionar tão bem em 2011 como funcionou em 2010, o ano será emocionante.”

Era de interesse da equipe que o “Grande Colisor de Hádrons” estivesse em funcionamento até o final de 2011 e somente no ano seguinte viesse a pausa técnica para que o mesmo funcionasse com altas energias, de 7 TeV.

Como a equipe de cientistas obteve um “bom funcionamento“ do acelerador em 2010, ela decidiu repensar a data de pausa em um ano para assim colherem mais dados.

O Efeito Fotoelétrico

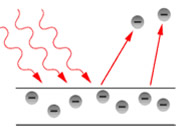

A emissão de elétrons de uma superfície em razão da interação de uma onda eletromagnética com a mesma é chamada efeito fotoelétrico.

Interação entre radiação eletromagnética e uma superfície resultando no efeito fotoelétrico

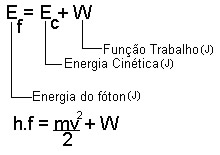

A descoberta desse efeito ocorreu entre 1886 e 1887 por Henrich Hertz, que usou a física clássica para explicá-lo. Os conceitos clássicos tornaram a concepção desse fenômeno insuficiente, dando lugar aos conceitos modernos proposto por Albert Einstein no ano de 1905. Dentre as propostas de Einstein estão a quantização da energia, ou seja, para ocorrência da ejeção imediata de elétrons da superfície, a energia da radiação (ondas eletromagnéticas) estaria concentrada em pacotes (fótons) e não distribuída sobre a onda (previsão clássica). Demonstrou também que a velocidade com que os elétrons são ejetados não depende da quantidade de fótons emitidos, e sim da frequência que esses fótons possuem; relação que pode ser compreendida através da expressão a seguir.

Nessa expressão, podemos interpretar que a energia que o fóton possui, ao ser transferida para a superfície, é convertida em energia cinética (elétron com velocidade) mais a função trabalho (energia utilizada para remover o elétron do átomo).

Em razão desse trabalho, Albert Einstein, no ano de 1921, recebeu o Prêmio Nobel em física.

O enigma do éter

Para os antigos gregos o éter era um quinto elemento que formava uma esfera celestial fora da Terra.

Esse elemento, segundo a teoria grega antiga, era diferente dos elementos encontrados na Terra (ar, água, fogo e terra), isso porque seria algo mais magnífico e grandioso do que o ar que respiramos.

Acreditava-se que através do éter seria possível identificar se os corpos analisados estavam em movimento ou inertes.

Baseados nessa teoria, ou contra ela, os físicos começaram a analisar o comportamento da luz. Após tais observações, por volta do século XVII, duas teorias foram apresentadas.

A primeira foi a teoria de Newton, que acreditava que a luz era de natureza corpuscular. Para ele, a formação da luz acontecia por feixes de pequenas partículas.

Já a segunda teoria foi a de Huygens, que defendia o fato de a luz resultar de uma transmissão contínua de pressão de um meio mais relativo ao éter que o ar.

Newton realizou vários experimentos a fim de confirmar sua teoria e pôde concluir que a luz é o resultado de diversas cores, e não de apenas uma única cor. Ele acreditava que a luz era composta por um ou vários tipos corpusculares.

Segundo Newton, a velocidade da luz aumentaria ao passar de um meio menos denso para um mais denso. Ex.: A luz passando do vácuo para a água.

Fato que foi derrubado em 1850 por Foucault, ao provar que a teoria de Newton estava errada, e que a luz aumenta sua velocidade ao passar de um meio mais denso para um meio menos denso.

Huygens, por sua vez, acreditava que a luz provinha de um meio em oscilação, o que permite entendermos hoje que em um meio homogêneo e com características iguais, a onda se move mantendo sua forma durante todo o percurso: isso acontece com a condição de não haver obstáculos.

A ideia e as teorias sobre a existência do éter caíram por terra quando Albert Einstein publicou e mostrou ao mundo sua Teoria da Relatividade, na qual provou que não podemos nos basear num referencial absoluto, em razão das constantes mudanças que acontecem na natureza.